[ISNLP 오픈 튜토리얼] 8일차: Pre-trained Model과 Hugging Face

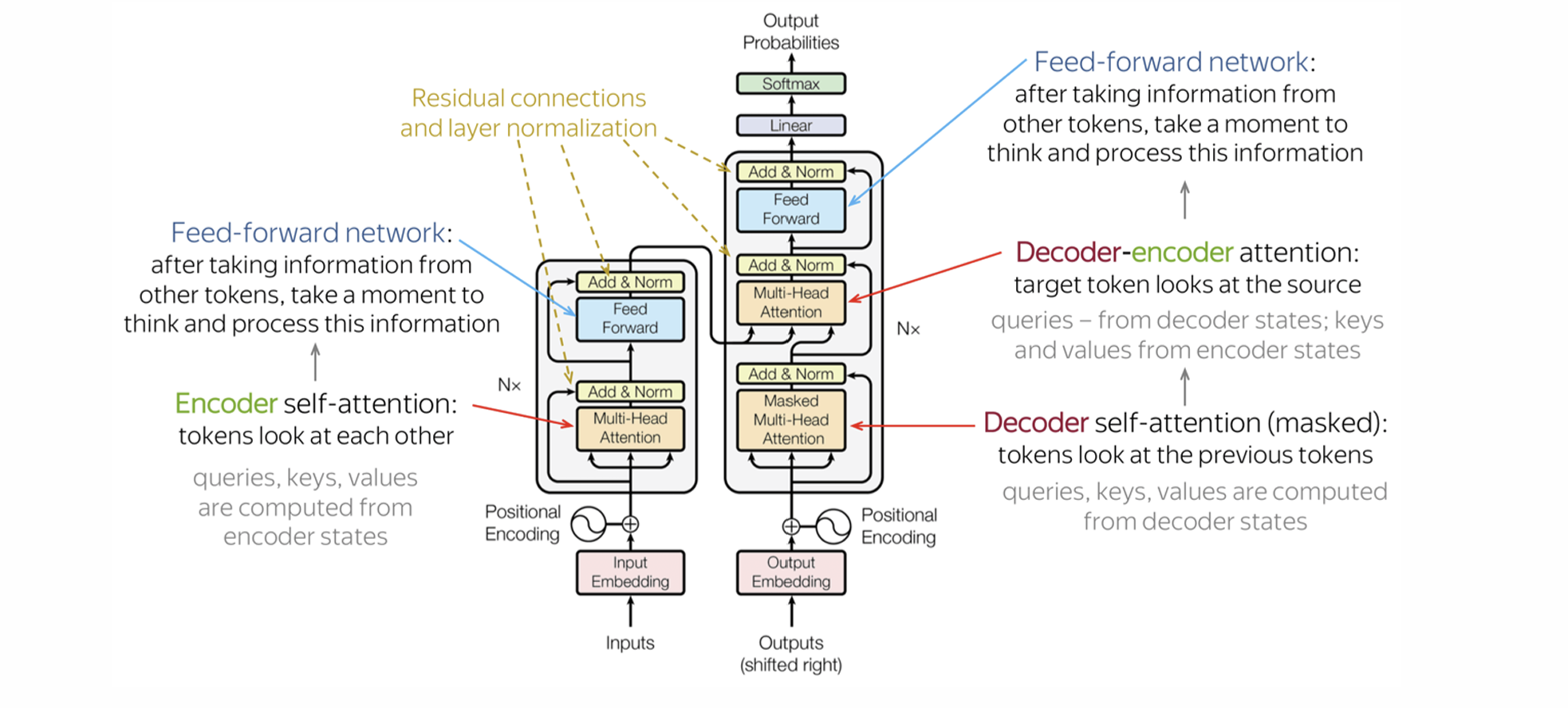

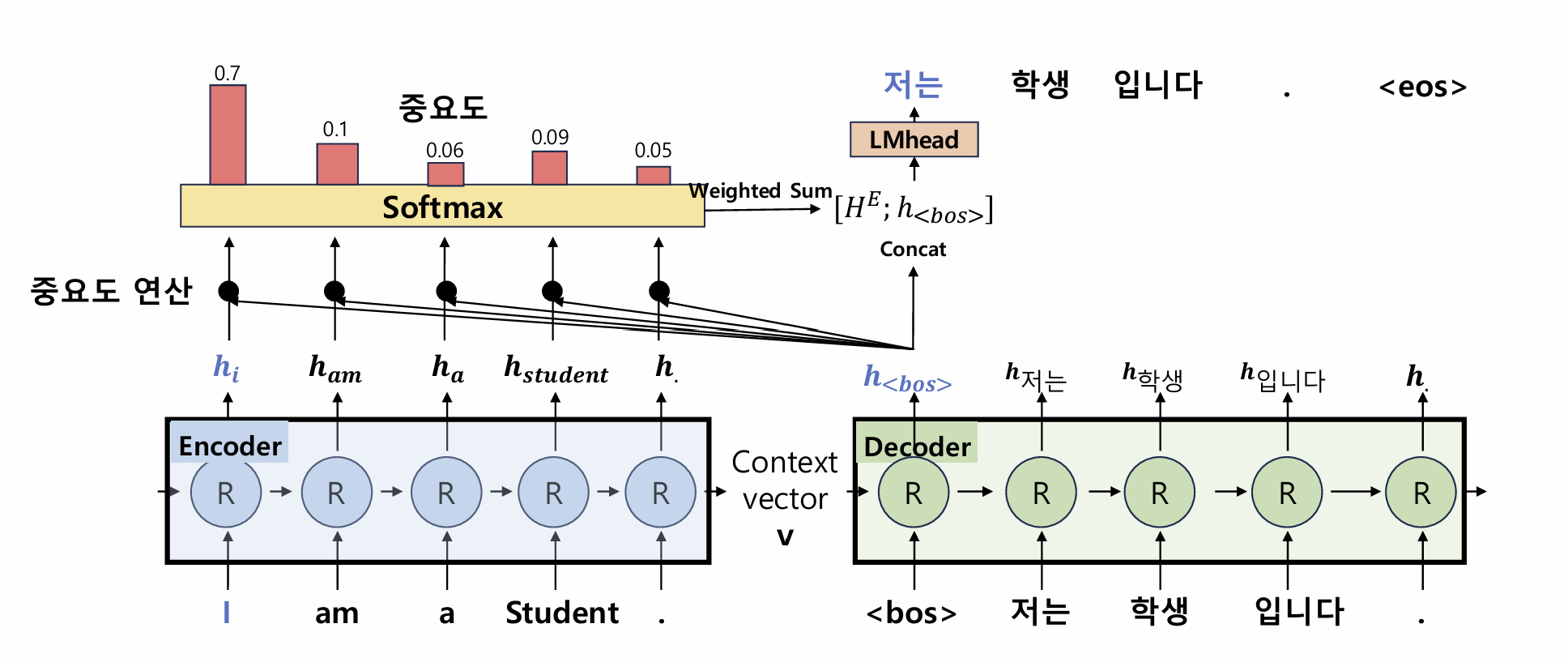

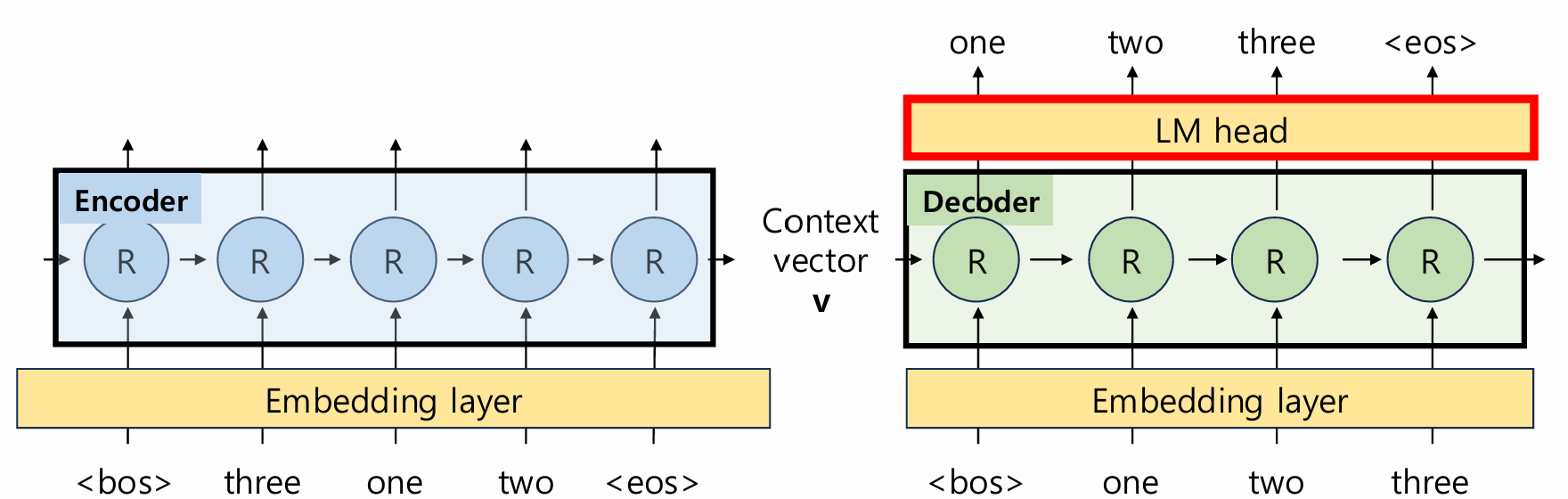

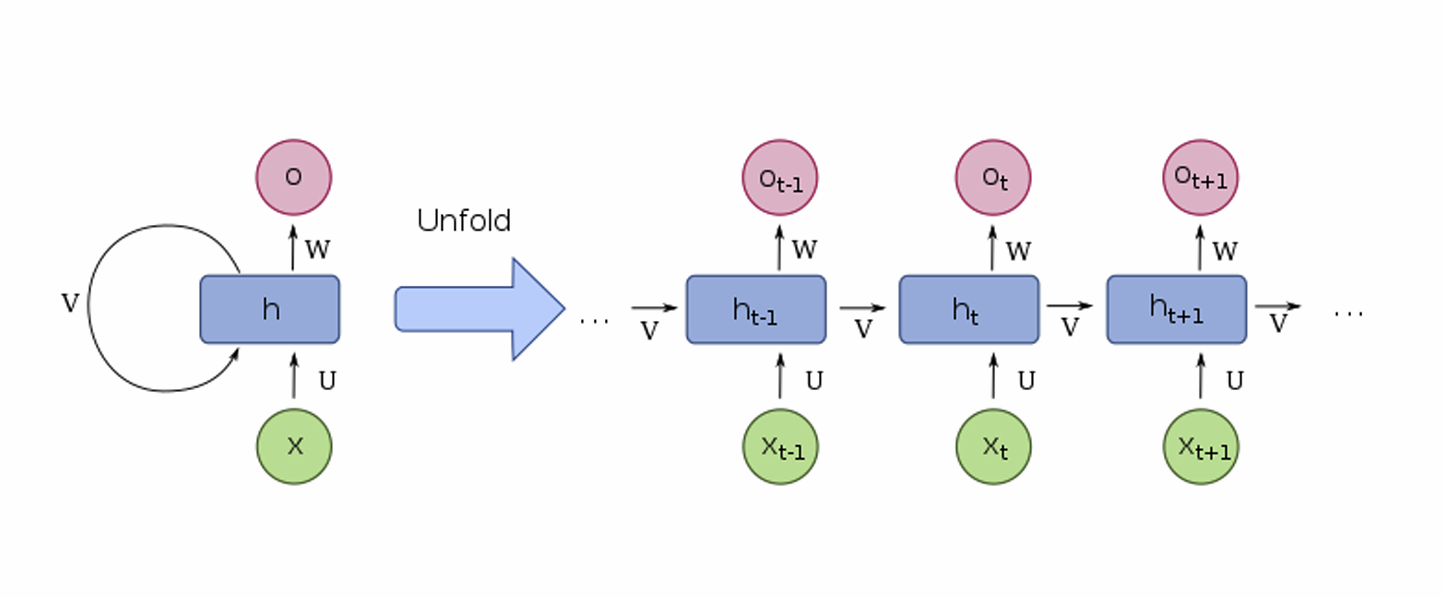

8일차: Pre-trained Model과 Hugging Face 이번 8일차 수업에서는 사전학습(Pre-train)된 모델과 Hugging Face 생태계를 중심으로 최신 NLP 모델 활용법을 배웠다. BERT, GPT, T5, BART와 같은 최신 Transformer 계열 모델과 Hugging Face 라이브러리를 배우면서 앞으로의 학습·프로...